یادگیری ماشین (Machine Learning) یکی از تأثیرگذارترین فناوریهای دوران معاصر است که انقلابی در نحوه پردازش دادهها و تصمیمگیری ایجاد کرده است. از الگوریتمهای سادهای که در دهه ۱۹۵۰ مطرح شدند تا شبکههای عصبی پیچیده و مدلهای مبتنی بر یادگیری عمیق امروزی، این حوزه به شکلی خیرهکننده تکامل یافته است. اما چگونه این فناوری شکل گرفت و مسیر پر فراز و نشیب آن چه درسهایی به ما میدهد؟ در این مقاله، تاریخچه یادگیری ماشین را بهصورت جامع بررسی میکنیم و به نقاط عطفی که این مسیر را رقم زدند، میپردازیم.

تعریف یادگیری ماشین

یادگیری ماشین علمی است که به ماشینها امکان میدهد بدون نیاز به برنامهریزی مستقیم، از دادهها یاد بگیرند و عملکرد خود را با تجربه بهبود بخشند. برخلاف برنامهنویسی سنتی، که در آن رفتار ماشین بهصورت مستقیم تعریف میشود، یادگیری ماشین بر پایه ارائه دادههای ورودی و خروجی هدف بنا شده و ماشین با استفاده از الگوریتمهای خاص، الگوهایی در دادهها پیدا میکند.

چرا یادگیری ماشین اهمیت دارد؟

در دنیای امروز، دادهها به سرعت در حال تولید هستند. از پیامهای متنی گرفته تا تصاویر، ویدئوها و سیگنالهای حسگرها، حجم دادههای تولیدشده فراتر از توان پردازش انسانی است. یادگیری ماشین به ما کمک میکند این دادهها را تحلیل کنیم، الگوها را شناسایی کنیم و تصمیمات بهینه بگیریم. کاربردهای این فناوری شامل تشخیص بیماریها، پیشبینی رفتار مشتریان، بهینهسازی زنجیرههای تأمین، خودروهای خودران و حتی ایجاد آثار هنری است.

یادگیری ماشین در مقایسه با هوش مصنوعی و یادگیری عمیق

هوش مصنوعی (AI) به معنای کلی شبیهسازی تواناییهای شناختی انسان توسط ماشینهاست. یادگیری ماشین زیرشاخهای از هوش مصنوعی است که بر آموزش ماشینها برای یادگیری و تصمیمگیری تمرکز دارد. یادگیری عمیق (Deep Learning) نیز یکی از روشهای یادگیری ماشین است که بر پایه شبکههای عصبی چندلایه کار میکند و به تحلیل دادههای پیچیده کمک میکند.

دهه ۱۹۴۰: آغاز ایدهها و نظریههای اولیه

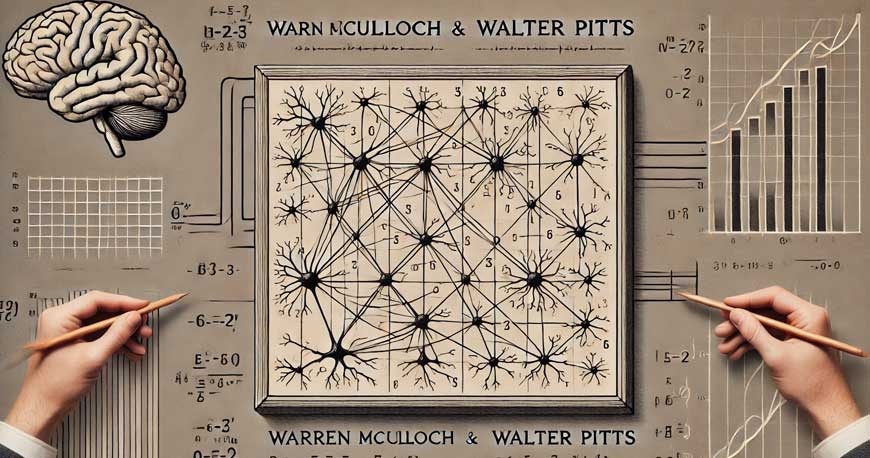

نورونهای مصنوعی: مدل مککالچ و پیتز (۱۹۴۳)

در سال ۱۹۴۳، وارن مککالچ و والتر پیتز، دو دانشمند برجسته در علوم اعصاب و ریاضیات، مقالهای منتشر کردند که اولین مدل ریاضی از نورونهای مصنوعی را معرفی کرد. این مدل بر اساس ایدهای ساده بنا شده بود: نورونها میتوانند سیگنالهای دریافتی را پردازش کرده و بر اساس آنها تصمیمگیری کنند.

ویژگیهای مدل مککالچ و پیتز:

- استفاده از منطق بولی:

آنها از منطق بولی برای شبیهسازی عملکرد نورونها استفاده کردند. هر نورون بهعنوان یک واحد تصمیمگیری عمل میکرد که ورودیها را دریافت کرده و بر اساس یک تابع ساده، خروجی تولید میکرد (مثلاً “روشن” یا “خاموش”). - مدلسازی شبکهای:

این مدل نشان داد که میتوان نورونهای مصنوعی را بهصورت شبکهای متصل کرد تا رفتارهای پیچیدهتری ایجاد شود. ترکیب چندین نورون مصنوعی به ماشینها این امکان را میداد که الگوهای پیچیدهتری را پردازش کنند. - سیستم دودویی:

در این مدل، ورودیها و خروجیها بهصورت دودویی (۰ و ۱) تعریف شده بودند که امکان شبیهسازی رفتارهای منطقی را فراهم میکرد.

اهمیت و تأثیرات این مدل:

- الهامگیری از عملکرد مغز:

این مقاله یکی از نخستین تلاشها برای شبیهسازی تصمیمگیری در مغز انسان بود. هرچند بسیار ساده بود، اما توانست توجه دانشمندان را به ارتباط بین علوم اعصاب و محاسبات جلب کند. - پایهگذاری شبکههای عصبی:

مفاهیمی که مککالچ و پیتز ارائه کردند، مستقیماً در توسعه شبکههای عصبی مصنوعی و یادگیری ماشین تأثیر گذاشت. ایده اتصال نورونها در یک شبکه، بعدها به ستون اصلی یادگیری ماشین تبدیل شد. - ایجاد زمینه برای سیستمهای محاسباتی هوشمند:

این مدل اولین گام به سمت طراحی سیستمهایی بود که بتوانند رفتارهای منطقی را تقلید کنند. اگرچه در ابتدا تنها بهصورت نظری بود، اما مفهوم آن بهطور گستردهای در حوزه یادگیری ماشین و هوش مصنوعی به کار گرفته شد.

نظریه اطلاعات: کلود شانون (۱۹۴۸)

یکی دیگر از دستاوردهای بزرگ دهه ۱۹۴۰، نظریه اطلاعات بود که توسط کلود شانون، ریاضیدان و مهندس برق، معرفی شد. در سال ۱۹۴۸، شانون مقالهای منتشر کرد که در آن مفهوم انتقال و پردازش دادهها را تعریف و استاندارد کرد. نظریه اطلاعات شانون بهعنوان یکی از بنیانهای یادگیری ماشین و علوم داده شناخته میشود.

اصول اصلی نظریه اطلاعات:

- کدگذاری دادهها:

شانون نشان داد که دادهها میتوانند به صورت عددی (صفر و یک) کدگذاری شوند. این ایده، پایهای برای ذخیرهسازی و انتقال دادهها در کامپیوترها شد. - انتقال اطلاعات:

او مفهومی به نام “ظرفیت کانال” را معرفی کرد که نشان میداد چقدر اطلاعات میتواند از یک کانال ارتباطی بدون از دست دادن داده منتقل شود. این مفهوم بهطور مستقیم در طراحی شبکههای کامپیوتری و سیستمهای یادگیری ماشین کاربرد پیدا کرد. - کاهش نویز:

شانون روشهایی را پیشنهاد داد که چگونه میتوان نویز را در انتقال دادهها به حداقل رساند. این ایده در یادگیری ماشین برای کار با دادههای ناقص یا نویزی بسیار مفید بود.

تأثیر نظریه اطلاعات بر یادگیری ماشین:

- ایجاد ساختار برای ذخیرهسازی و پردازش دادهها:

شانون اولین کسی بود که مفهوم داده را بهعنوان یک واحد پردازش تعریف کرد. این مفهوم امروزه در قلب یادگیری ماشین و علوم داده قرار دارد. - تحلیل الگوریتمها و بهینهسازی آنها:

مفهوم انتقال بهینه اطلاعات به توسعه الگوریتمهای یادگیری کمک کرد. در یادگیری ماشین، کاهش پیچیدگی محاسباتی و بهبود کارایی الگوریتمها از ایدههای شانون الهام گرفته شده است. - پیشرفت در پردازش سیگنال:

نظریه اطلاعات شانون در تحلیل و بهینهسازی سیگنالها استفاده شد که بعدها بهطور مستقیم در یادگیری ماشین برای پردازش تصاویر و دادههای صوتی به کار رفت.

نمونههای عملی از تأثیر شانون:

- فشردهسازی دادهها:

الگوریتمهای فشردهسازی مانند ZIP و JPEG از اصول نظریه شانون برای کاهش حجم دادهها بدون از دست دادن اطلاعات اصلی استفاده میکنند. - پردازش دادههای بزرگ:

ایدههای شانون در ذخیره و انتقال دادهها، بهطور مستقیم در کلان داده و سیستمهای مدرن یادگیری ماشین کاربرد دارد.

دهه ۱۹۵۰: تولد یادگیری ماشین

آلن تورینگ: ماشینهایی که میتوانند یاد بگیرند

در سال ۱۹۵۰، آلن تورینگ، نابغه ریاضی و علوم کامپیوتر، مقاله مشهور خود با عنوان “Computing Machinery and Intelligence” را منتشر کرد. این مقاله بهعنوان یکی از تأثیرگذارترین آثار در تاریخ هوش مصنوعی و یادگیری ماشین شناخته میشود. تورینگ در این مقاله سؤالی بنیادین مطرح کرد: «آیا ماشینها میتوانند فکر کنند؟»

مفهوم ماشینهای یادگیرنده:

تورینگ استدلال کرد که یک ماشین میتواند از طریق تعامل با محیط و دریافت بازخورد، تواناییهای خود را بهبود بخشد. این ایده، که بعدها به یادگیری ماشین مدرن تبدیل شد، بر پایه این فرضیه بود که ماشینها نیازی به برنامهریزی مستقیم برای یادگیری ندارند، بلکه میتوانند از دادهها و تجربیات خود بیاموزند.

تست تورینگ:

یکی از مهمترین مفاهیم معرفیشده در این مقاله، تست تورینگ بود. این آزمون معیاری برای سنجش هوش مصنوعی است که در آن یک ماشین باید توانایی تعامل با انسان را بهگونهای داشته باشد که انسان نتواند تشخیص دهد طرف مقابل ماشین است یا انسان دیگر. اگر ماشین موفق به عبور از این آزمون شود، میتوان گفت که تواناییهای هوشمندانه دارد.

تأثیرات نظریه تورینگ:

- تعریف هوش مصنوعی: این مقاله اولین تعریف رسمی از هوش مصنوعی و توانایی یادگیری ماشین را ارائه داد.

- الهامبخش تحقیقات آینده: مفهوم ماشینهای یادگیرنده راه را برای توسعه الگوریتمها و مدلهای یادگیری ماشین هموار کرد.

- استانداردسازی ارزیابی هوش مصنوعی: تست تورینگ به معیاری استاندارد برای سنجش تواناییهای سیستمهای هوشمند تبدیل شد.

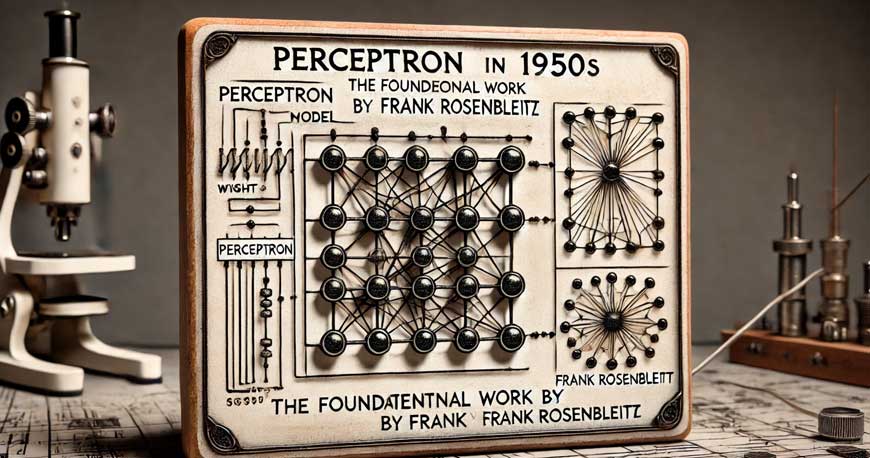

پرسپترون: اولین الگوریتم یادگیری ماشین

در سال ۱۹۵۷، فرانک روزنبلات، دانشمند علوم کامپیوتر، مدل پرسپترون را معرفی کرد که بهعنوان اولین الگوریتم یادگیری ماشین شناخته میشود. پرسپترون یک شبکه عصبی تکلایه بود که میتوانست الگوهای ساده را شناسایی کند و برای دستهبندی دادهها بهکار رود. این مدل، اولین تلاش عملی برای شبیهسازی رفتار نورونهای انسانی در سیستمهای محاسباتی بود.

نحوه عملکرد پرسپترون:

پرسپترون از یک لایه نورون مصنوعی تشکیل شده بود که ورودیهای داده را دریافت میکرد و با استفاده از وزندهی و یک تابع آستانه (Threshold Function)، تصمیم میگرفت که داده به کدام دسته تعلق دارد. اگر مجموع وزندهی ورودیها از مقدار آستانه بیشتر بود، پرسپترون آن را به یک دسته خاص اختصاص میداد.

موفقیتهای پرسپترون:

- تشخیص الگوهای ساده: پرسپترون در تشخیص اعداد و حروف ساده کاربرد داشت.

- الهامبخش الگوریتمهای آینده: این مدل، پایهای برای شبکههای عصبی پیچیدهتر مانند شبکههای چندلایه (MLP) شد.

محدودیتهای پرسپترون:

هرچند پرسپترون یک دستاورد مهم بود، اما محدودیتهایی نیز داشت. یکی از بزرگترین مشکلات آن، ناتوانی در یادگیری الگوهای غیرخطی بود. بهعنوان مثال، پرسپترون نمیتوانست مسئله XOR را حل کند. این محدودیتها، که در کتاب مشهور “Perceptrons” توسط ماروین مینسکی و سیمور پاپرت برجسته شدند، باعث کاهش علاقه به شبکههای عصبی در دهههای آینده شد.

دهه ۱۹۶۰: گسترش الگوریتمها و چالشها

ظهور الگوریتمهای ابتدایی

در دهه ۱۹۶۰، محققان به این نتیجه رسیدند که برای حل مسائل پیچیده، به الگوریتمهایی نیاز دارند که بتوانند بهصورت خودکار از دادهها بیاموزند. تعدادی از الگوریتمهایی که در این دوره معرفی شدند، هنوز هم در یادگیری ماشین مدرن استفاده میشوند.

1. رگرسیون خطی

رگرسیون خطی یکی از قدیمیترین و پراستفادهترین روشهای آماری است که در این دهه برای پیشبینی دادههای عددی استفاده شد. این روش بر اساس رابطه خطی بین یک متغیر مستقل (X) و متغیر وابسته (Y) کار میکند. در یادگیری ماشین، رگرسیون خطی برای پیشبینی مقدارهای عددی و یافتن روابط خطی میان دادهها به کار گرفته میشود.

ویژگیهای کلیدی رگرسیون خطی:

- ساده و قابل تفسیر.

- مناسب برای مجموعه دادههای کوچک.

- عملکرد محدود در مسائل غیرخطی.

2. الگوریتم K-Nearest Neighbors (KNN)

الگوریتم KNN یکی از اولین روشهای دستهبندی (Classification) بود که در این دهه معرفی شد. این الگوریتم از اصل مجاورت در فضای ویژگیها استفاده میکند. KNN برای هر داده جدید، نزدیکترین همسایهها را در مجموعه داده پیدا کرده و بر اساس برچسبهای آنها، دستهبندی میکند.

کاربردهای KNN:

- دستهبندی تصاویر.

- پیشبینی رفتار مشتریان.

- تحلیل دادههای زیستی.

3. درختهای تصمیمگیری

درختهای تصمیمگیری بهعنوان یک ابزار ساده و قدرتمند برای حل مسائل طبقهبندی و پیشبینی معرفی شدند. این روش دادهها را به مجموعهای از تصمیمات متوالی تقسیم میکند و در نهایت به یک نتیجه میرسد. درختهای تصمیمگیری به دلیل ساختار بصری و قابل تفسیر خود، در بسیاری از مسائل کاربرد داشتند.

روشهای احتمالاتی و یادگیری ماشینی

دهه ۱۹۶۰ همچنین شاهد گسترش استفاده از روشهای احتمالاتی در یادگیری ماشین بود. این روشها امکان تحلیل دادههای ناقص یا پر از نویز را فراهم کردند و بهعنوان یکی از ابزارهای استاندارد در یادگیری ماشین شناخته شدند.

1. توزیع نرمال و مفاهیم آماری

یکی از مفاهیمی که در این دهه بهطور گسترده مورد استفاده قرار گرفت، توزیع نرمال بود. این توزیع که به آن توزیع گوسی نیز میگویند، برای تحلیل دادههایی که بهطور طبیعی حول یک مقدار میانگین توزیع شدهاند، بهکار رفت. بسیاری از مدلهای یادگیری ماشین از این توزیع برای تحلیل دادهها و پیشبینی نتایج استفاده میکنند.

2. نظریه بیز و مدلهای بیزین

نظریه بیز، که بر پایه احتمال شرطی بنا شده است، یکی از مهمترین مفاهیم ریاضی در یادگیری ماشین است. این نظریه در این دهه بهطور گسترده مورد توجه قرار گرفت و به بخشی جداییناپذیر از بسیاری از مدلهای یادگیری تبدیل شد.

کاربردهای مدلهای بیزین:

- فیلتر کردن اسپم در ایمیلها.

- پیشبینی بیماریها در پزشکی.

- تحلیل دادههای ژنتیکی.

دهه ۱۹۷۰: اولین زمستان هوش مصنوعی

کاهش علاقه و حمایت مالی

انتظارات غیرواقعی

در دهههای پیشین، هوش مصنوعی و یادگیری ماشین با تبلیغات و وعدههای بزرگی همراه بودند. محققان و رسانهها، این فناوری را بهعنوان ابزاری برای حل تمامی مسائل بشری معرفی کردند. برخی از پروژههای اولیه هوش مصنوعی حتی وعده داده بودند که ماشینها میتوانند در عرض چند سال رفتارهای انسانی را بهطور کامل تقلید کنند. این امیدواریها باعث شد که سرمایهگذاران و دولتها بودجههای کلانی را به این حوزه اختصاص دهند.

نتایج محدود

با وجود این حمایتها، فناوری موجود و دانش علمی در آن زمان قادر به تحقق این وعدهها نبود. الگوریتمهای اولیه، توانایی کافی برای حل مسائل پیچیده نداشتند و قدرت محاسباتی کامپیوترها برای اجرای مدلهای پیشرفته کافی نبود. در نتیجه، پروژههای هوش مصنوعی و یادگیری ماشین به موفقیتهای چشمگیری دست نیافتند. این وضعیت باعث شد سرمایهگذاران بهتدریج حمایت مالی خود را کاهش دهند و علاقه عمومی به این فناوری کمرنگ شود.

محدودیتهای سختافزاری

قدرت پردازشی ناکافی

در دهه ۱۹۷۰، کامپیوترها بههیچوجه توانایی اجرای الگوریتمهای پیچیده یادگیری ماشین را نداشتند. پردازندههای آن زمان برای اجرای محاسبات سنگین بسیار کند بودند. بهعنوان مثال:

- شبکههای عصبی مصنوعی:

این شبکهها به حجم بالایی از محاسبات ماتریسی نیاز داشتند که کامپیوترهای آن زمان نمیتوانستند بهسرعت انجام دهند. - مدلهای احتمالاتی:

تحلیل دادههای حجیم یا دارای نویز، به منابع محاسباتی قویتر نیاز داشت که در دسترس نبود.

حافظه محدود

حافظه کامپیوترها نیز یکی دیگر از موانع بزرگ در این دوره بود. بسیاری از مدلها برای یادگیری و ذخیره الگوها به فضای حافظه بیشتری نیاز داشتند که در آن زمان در دسترس نبود. این محدودیت باعث میشد که محققان نتوانند مدلهای یادگیری ماشین را با دادههای واقعی آموزش دهند.

فقدان دادههای دیجیتال

یکی از مشکلات دیگر این دوره، کمبود دادههای دیجیتال قابل استفاده برای آموزش مدلها بود. دادههای دیجیتال در مقیاس بزرگ هنوز وجود نداشتند و محققان مجبور بودند از دادههای کوچک و محدود استفاده کنند که این موضوع کارایی مدلها را کاهش میداد.

دهه ۱۹۸۰: بازگشت یادگیری ماشین به مسیر پیشرفت

معرفی الگوریتم بازگشت به عقب (Backpropagation)

یکی از بزرگترین دستاوردهای دهه ۱۹۸۰، توسعه الگوریتم بازگشت به عقب بود که فرآیند آموزش شبکههای عصبی را کارآمدتر کرد. این الگوریتم با محاسبه گرادیان خطا و تنظیم وزنهای نورونها، آموزش شبکههای چندلایه را ممکن ساخت. بازگشت به عقب باعث شد شبکههای عصبی بار دیگر به ابزار مفیدی برای یادگیری ماشین تبدیل شوند.

ظهور یادگیری تقویتی

یادگیری تقویتی (Reinforcement Learning) نیز در این دهه معرفی شد. این روش به ماشینها امکان میداد از طریق تعامل با محیط و دریافت پاداش یا تنبیه، استراتژیهای بهینهای را یاد بگیرند. این مفهوم بعدها در بازیها و رباتیک مورد استفاده قرار گرفت.

دهه ۱۹۹۰: عصر کلان داده و الگوریتمهای پیشرفته

رشد دادههای دیجیتال

دهه ۱۹۹۰ با ظهور اینترنت و رشد دادههای تولیدشده همراه بود. این دادهها که بعدها به “کلان داده” معروف شدند، به الگوریتمهای یادگیری ماشین امکان دادند تا با مجموعههای داده واقعی و حجیم کار کنند.

الگوریتمهای جدید: SVM و Random Forest

- ماشینهای بردار پشتیبان (SVM): این الگوریتم برای دستهبندی دادههای پیچیده طراحی شد و توانست در بسیاری از مسائل کاربردی موفق عمل کند.

- جنگل تصادفی (Random Forest): یک روش مبتنی بر درختهای تصمیمگیری که به دلیل دقت و انعطافپذیری، به یکی از ابزارهای اصلی یادگیری ماشین تبدیل شد.

دهه ۲۰۰۰: یادگیری عمیق و پیشرفتهای عظیم

شبکههای عصبی چندلایه (Deep Neural Networks)

در دهه ۲۰۰۰، با افزایش قدرت محاسباتی و دسترسی به دادههای بزرگ، شبکههای عصبی چندلایه توانستند مشکلات پیچیدهتری مانند تشخیص تصویر و پردازش زبان طبیعی را حل کنند.

ابزارهای متنباز

ابزارهایی مانند TensorFlow و PyTorch توسعه مدلهای یادگیری ماشین را سادهتر کردند و به محققان این امکان را دادند که با منابع کمتری مدلهای پیشرفتهای بسازند.

دهه ۲۰۱۰: ظهور مدلهای مولد و ترانسفورمرها

پیشرفتهای شبکههای عصبی عمیق

شبکههای عصبی عمیق که در دهههای پیشین معرفی شده بودند، با افزایش قدرت پردازش گرافیکی (GPU) و طراحی الگوریتمهای بهینه، در دهه ۲۰۱۰ به اوج خود رسیدند. الگوریتمهایی مانند شبکههای عصبی کانولوشن (CNN) و شبکههای عصبی بازگشتی (RNN) توانستند در زمینههایی مانند تشخیص تصویر، پردازش زبان طبیعی و تحلیل ویدئو عملکردی استثنایی ارائه دهند.

کاربردهای یادگیری عمیق

- تشخیص تصویر و ویدئو:

مدلهایی مانند AlexNet (2012) و ResNet (2015) در مسابقات تشخیص تصویر مانند ImageNet تحولی ایجاد کردند. - پردازش زبان طبیعی (NLP):

استفاده از RNNها و LSTMها برای تحلیل متن، ترجمه زبان و چتباتها رایج شد. - شناسایی گفتار:

شرکتهایی مانند گوگل، آمازون و مایکروسافت از یادگیری عمیق برای بهبود دستیارهای صوتی مانند Alexa، Siri و Google Assistant استفاده کردند.

مدلهای مولد و یادگیری بدون نظارت

مدلهای مولد تخاصمی (GANها)

در سال ۲۰۱۴، مدلهای مولد تخاصمی (GANs) توسط ایان گودفلو معرفی شدند. این مدلها شامل دو شبکه عصبی بودند که در مقابل یکدیگر آموزش میدیدند: یک تولیدکننده (Generator) برای تولید دادههای مصنوعی و یک تشخیصدهنده (Discriminator) برای تمایز بین دادههای واقعی و مصنوعی.

کاربردهای GANها:

- تولید تصاویر و ویدئوهای مصنوعی.

- بهبود کیفیت تصاویر (Super-Resolution).

- ایجاد هنر دیجیتال.

یادگیری انتقالی (Transfer Learning)

یادگیری انتقالی که در این دهه رواج یافت، امکان استفاده از مدلهای از پیشآموزشدیده را در مسائل جدید فراهم کرد. این روش زمان آموزش را کاهش داد و عملکرد مدلها را بهبود بخشید.

معماری ترانسفورمرها و مدلهای زبان طبیعی

ظهور ترانسفورمرها

در سال ۲۰۱۷، مقالهای از گوگل با عنوان “Attention Is All You Need” معماری ترانسفورمرها را معرفی کرد. این معماری، که جایگزین روشهای قدیمیتر مانند RNNها شد، امکان پردازش موازی دادهها را فراهم کرد و عملکرد قابلتوجهی در پردازش زبان طبیعی داشت.

مدلهای پیشرفته زبان (GPT و BERT)

- GPT (Generative Pre-trained Transformer):

مدل GPT که توسط OpenAI توسعه داده شد، قابلیت تولید متنهای طبیعی و منسجم را بهطور گسترده بهبود داد. نسخههای پیشرفتهتر مانند GPT-2 و GPT-3 کاربردهای گستردهای در تولید محتوا، ترجمه و پاسخ به سوالات پیدا کردند. - BERT (Bidirectional Encoder Representations from Transformers):

این مدل که توسط گوگل معرفی شد، قابلیت درک معنایی متن را با استفاده از تحلیل دوسویه کلمات ارتقا داد. BERT برای جستجو در موتورهای جستجو و تحلیل دادههای متنی کاربرد فراوانی داشت.

جمعبندی

تاریخچه یادگیری ماشین، داستانی از نوآوری، شکست و موفقیت است. از نظریههای اولیه دهه ۱۹۴۰ تا پیشرفتهای شگفتانگیز یادگیری عمیق، این فناوری به یکی از ابزارهای کلیدی در زندگی مدرن تبدیل شده است. آینده یادگیری ماشین، با ورود فناوریهای کوانتومی و مدلهای هوش عمومی، حتی هیجانانگیزتر خواهد بود . اگر علاقهمند به یادگیری ماشین هستید، اکنون بهترین زمان برای شروع است. با دورههای آموزشی و منابع آنلاین، میتوانید مهارتهای خود را در این حوزه گسترش دهید و به بخشی از این انقلاب فناورانه تبدیل شوید